Nach einem Arte Beitrag über Wikipedia begannen Diskussionen darüber, ob die Wikipedia Nutzer Aka oder Invisigoth67 Bots seien oder nicht. Angesichts von hochgerechnet mehreren hundert Edits pro Tag darf dies zumindest bezweifelt werden. Deshalb stellt sich die Frage, was die ca. 1600 Bots in der englischsprachigen und ca. 400 Bots in der deutschsprachigen Wikipedia genau tun und wer sie bei ihrer Arbeit überwacht.

Welche Arten von Bots gibt es?

Die meisten Bots erledigen Routineaufgaben, sie finden Fehler in Rechtschreibung oder Grammatik, entfernen Links oder verschieben Artikel in Kategorien. Hauptsächlich basieren sie auf dem in der Programmiersprache Python verfassten Skript Pywikibot. Darüber hinaus können manche Bots schon im Internet verfügbare Informationen aktuell halten. Als Beispiel seien dafür Umsatz und Gewinn börsennotierter Konzerne genannt. Ein Großteil der von Bots bei Wikipedia verrichteten Arbeit sind also anspruchslose Routineaufgaben. In einigen fremdsprachigen Wikipedias werden bereits Bots eingesetzt, um Artikel zu „verfassen“. Dabei legen sie leere Artikel zu Themen von Relevanz an. Warum könnten Bots sinnvoll sein? Die Wikipedia hat ein Personalproblem. Sie schafft es unverändert nicht, genügend motivierte Autoren zu finden. Das ist jedoch gleich aus mehreren Grünen dringend notwendig:

1. Damit die Wikipedia mehr ist als nur ein Onlineforum für wenige Schreibwütige, braucht sie qualitativ hochwertige Artikel. Damit die Masse der Artikel gut ist, braucht es viele Autoren. Kurz gesagt: ohne Schwarm keine Schwarmintelligenz!

2. Die Aktualisierung vorhandener Artikel ist aufgrund ihrer schieren Masse eine Sisyphusaufgabe, die mit der vorhandenen Menge an (aktiven) Autoren kaum durchgeführt werden kann. Zumindest nicht ohne Abstriche bei der Qualität, insbesondere Richtigkeit, Präzision und Neutralität. Kurz gesagt: Ohne Schwarmintelligenz gibt es statt freiem Wissen vor allem freies Halbwissen. Viele Versuche, mehr Autoren und insbesondere auch Autorinnen zu finden, schlugen bislang fehl. Es ist also nur folgerichtig, dass die Wikipedia versucht Routineaufgaben zu automatisieren.

Was genau ist kritisch am Einsatz von Bots?

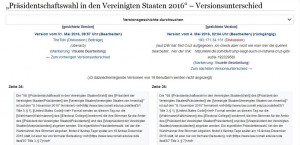

Es wird bei vielen Benutzern nicht benannt, wenn diese mit Bots arbeiten. Das schadet der Transparenz hinter Wikipedia. Nicht jeder eingesetzte Bot wird allem Anschein nach als solcher gekennzeichnet, obwohl die Regeln der Wikipedia da so vorsehen. Wie kommen zum Beispiel die Eingangs erwähnten Benutzer Aka und Invisigoth67 zu so vielen Edits? Die Antwort ist einfach: Ohne einen gewissen Grad an Automatisierung ist das schlicht und einfach nicht möglich. Warum werden solche Accounts nicht gekennzeichnet? Auch hier zeigt sich was für fast alle Regeln der Wikipedia gilt: Alle Autoren sind gleich. Aber manche sind gleicher als die anderen. Die beiden Nutzer rechtfertigen die nicht vorhandene Kennzeichnung dadurch, dass sie die vom Bot gefunden Fehler selbst korrigieren würden. Selbst wenn man davon ausgeht, dass das richtig ist, trägt es nicht zur Transparenz bei. Wer garantiert denn, dass in der Wikipedia nicht schon längst Texte von Bots produziert werden, oder dass Bots beim Versuch Paid Editing zu verhindern, Inhalte zensieren?

Fazit:

Das eigentliche Problem der Wikipedia können Bots nicht lösen: Sie hat zu wenige Autoren, um ihren eigenen Ansprüchen gerecht zu werden. Das liegt daran, dass ihre Strukturen für Neueinsteiger nur schwer zu durchschauen sind und ältere Wikipedianer bevorzugen. Hinzu kommt, dass die Wikipedia mit veralteten und unnötig komplizierten Benutzeroberflächen sowie einem rauen Umgangston sehr viele motivierte Freiwillige abschreckt. An diesen Punkten zu arbeiten, bedeutet dicke Bretter zu bohren. Routineaufgaben sollten jedoch noch stärker transparent an Bots delegiert werden. Menschliche Autoren können sich dann den Tätigkeiten widmen, die auch nur von Menschen ausgeführt werden können. Das Verfassen, korrigieren und verbessern von sachlich richtigen, präzisen lexikalischen Artikeln.